Bármilyen hihetetlen is, rettentő izgalmas időket élünk jelenleg, ha csak és kizárólag a videokártyák szegmensét nézzük. Pár hónappal ezelőtt még nem így fogalmaztunk, keseregtünk a magas árak és a kissé foghíjas készletek miatt, az alsó kategóriás modellek pedig egyszerre okoztak derűt és idegbajt szemtelenül végletekig spórolós felépítésük és tudásuk miatt. Álmodoztunk "jóárasított" RTX 4060-ról, illetve néha-néha eszünkbe jutott, hogy elvileg az Intel is készül valamivel a diszkrét VGA-k piacára; csak épp még mindig nem látta senki a kész produktumokat.

Most pedig itt az év vége, és tranzisztorok milliárdjai a legmodernebb képfeldolgozó technológiákkal megerősítve rázzák fel a játékosokat az éber álomból.

Megérkezett az új GeForce szörnyeteg, az Intel pedig végre tényleg megmutatta, hogy nem csak processzort képes megfelelő minőségben gyártani. Eközben az AMD vadul árat csökkent, mi pedig örvendezünk, hogy újra történik valami, ami kedvező lehet a felhasználók számára.

Valahogy így indult az XGI története is, bár hozzá kell tenni, hogy a 2000-es évek elején a VGA-szektort teljesen más mechanizmusok jellemezték. Nyugodtabb környezetben és klasszikus útitervek mentén haladt előre a két nagy versenytárs, akikhez egyszer csak becsatlakozott egy harmadik szereplő azzal a nem titkolt céllal, hogy megkaparintsa a 3D-s trónt.

Múltból építkező csapat

A 2003-ban alapított XGI (eXtreme Graphics Innovation) amolyan váratlan üstökösként csapódott be az iparágba, legalábbis első látásra úgy tűnt, hogy szinte a semmiből érkezik egy "kész" vállalat, amely épphogy berendezkedik az irodaépületben, máris teljes termékcsaládra vonatkozó útitervvel és az első nagy bejelentéssel lep meg mindenkit. Ráadásul a kezdés igen ütősre sikerült, a Volari V8 Duo Ultra rögtön két GPU-val támadta az akkori GeForce és Radeon csúcsmodelleket, a gyártói kommunikáció pedig annyira magabiztos volt, hogy a többség megszeppenve, csendben várta, hogy miképp kerül fel a korona a Volari csúcskártyára.

Ahogy egyre több adat kiderült a vezérlőről, illetve magáról az XG40 kódnéven gyártott grafikus lapkáról, szép lassan be lehetett állni az XGI csapatának vágyai mögé, újságírói szempontból egészen izgalmas jövőkép rajzolódott ki, a játékosok felhasználói bázisa pedig csak örült, hogy több, magas 3D-s teljesítményre képes opció közül választhat.

Ráadásul a vállalat mögött a SiS-től érkező mérnöki tudás és a Trident grafikus "know-how"-ja állt, ami megalapozott egyfajta bizalmat még úgy is, hogy ez a két márka nem éppen arról lett híres, hogy kiemelkedőt alkottak volna a 3D-s képgenerálás terén.

A helyzet az, hogy a teljes képet tekintve talán most már kimondhatjuk, hogy az XGI meglehetősen rövid pályafutása javarészt e csapat múltban ragadásának köszönhető. Ez pedig annak ellenére megállja a helyét, ha a friss lendülettel és elszántsággal rendelkező részlegeknek alapvetően idejük sem volt a Volari finomhangolására, a hiányos technológiai repertoár és a gyorsan piacra dobott termék pedig végül kisebb PR-katasztrófát okozott.

Nagyon félrement valami

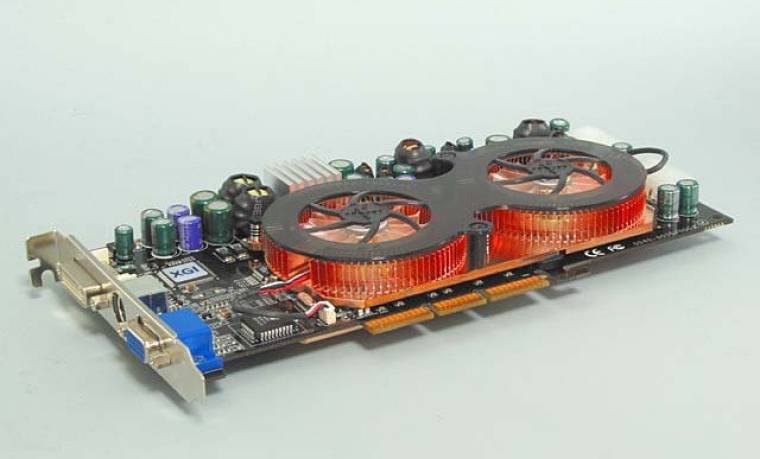

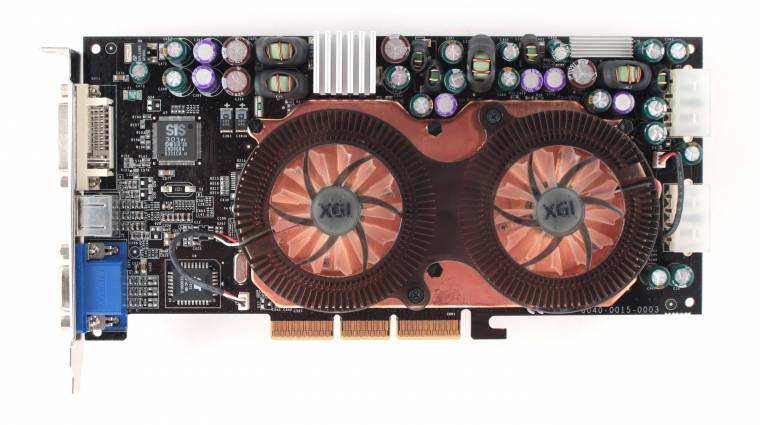

Az első tesztkártyákat a Club3D juttatta el a techsajtó számára, és a teljes kudarcot talán az jellemzi legjobban, hogy egyesek őket mint partnergyártót sajnálták a legjobban, amiért piacra kell dobniuk a két GPU-s újdonságot. A kártya felépítése még mindig az ígért erőt sugározta, a kétventilátoros hűtés egyértelműen jelezte, hogy ez egy csúcshardver, amit csak kevesen engedhetnek majd meg maguknak. A két Molex tápcsatlakozó jelenléte viszont inkább ijesztő volt, ekkoriban nagyon nem az volt a jellemző, hogy ennyi plusz energiára lenne szükség egy VGA meghajtásához.

A tízrétegű nyomtatott áramköri lap felső részére integrált tápvezérlő alkatrészek látszólag épphogy felfértek, és egy-két komponens külön hűtőborda segítségével próbálta átvészelni a terhelési csúcsokat. Igazság szerint nem a két lapkának kellett ilyen összetett tápellátás, a 130 nm-es gyártástechnológián készülő XG40 mindössze 20 wattot igényelt, ennek megduplázása sem okoz még komolyabb terhet, a 2×128 MB-nyi DDR2-es memória azonban falta a wattokat. Az 1 GHz effektív órajelre hitelesített Samsung lapkákat ugyan csak 900 MHz-en járatták, GPU-nként nyolc darab került a nyomtatott áramkörre, így nem csoda, hogy a kártya hátlapját egy méretes hűtőborda fedte be.

Nézegetve és kézbe véve a Volari Duót, egy technológiai demonstrációt láthattunk, avagy erre képes most egy gyártó, ha két GPU-s erőfölényt akar kiépíteni a versenytársak ellenében.

Tényleg pazar és egyszerre kevéssé költséghatékony, de az XGI üdvöskéje nem is arra készült, hogy a tömegek választása legyen. Egyszerre csúcsmodell és reklámeszköz; sajnos ez utóbbi szerepe miatt lett baj a bemutatkozást követően.

Valaki tudja, hol a driver?

Azzal sosincs baj, ha egy új hardverszereplő olyan eszközillesztő programot készít, ami nem a megszokott sémák alapján épül fel, nem ugyanúgy lehet állítani benne az egyes paramétereket, illetve itt-ott kissé logikátlan a kezelőfelület. Láttunk már ilyet, sőt a két nagy piaci szereplőtől sem voltak szokatlanok a furcsa driveres húzások. Na de amit az XGI produkált, az felejthetetlenül kínosra sikerült. Tény, hogy valami feltelepült, ami aztán azt a látszatot keltette, hogy ugyanúgy minden elérhető és beállítható, mint más kártyák esetében, de pár játék futtatása után gyorsan kiderült, hogy nemcsak az ígért sebességbeli fölény nem lesz meg, komoly képi anomáliákkal is találkozhattak a szerencsés tesztelők. Egy-két szintetikus tesztben tényleg kijött a két grafikus lapka ereje és a köztük lévő összeköttetés működési elgondolása, de a játékok többségében csalódást keltő számokat generált a Volari. Hol nem látszott a második GPU extra ereje, hol az egész rendszer önmagát lassította a kettős képfeldolgozás miatt; valami nagyon nem stimmelt a parancsfeldolgozásban és az eszközillesztő működésében.

Az első Far Cry rész tesztköreit pedig inkább ignorálni kellett, hiszen míg az Nvidia és az ATI kártyáin rendben megjelentek a különböző shaderalapú látványelemek, addig az XGI ezeket szimplán nem jelenítette meg, így rövidebb renderidővel és magasabb képkockasebességgel versenyeztek.

Csalást nem kiáltana senki, de ez így nagyon nem az a technológiai szint, ami elfogadható, illetve pénzért cserébe kínálható.

Gyors elsüllyedés

Sosem sikerült a driveres hibák tömkelegének kijavítása. Az óriási optimalizációs hátrány végül darabokra szakította az XGI csapatát, és 2006-tól már csak egy, ipari célokra bevethető fejlesztés maradt a Volari családból. Végül 2010-ben bezárult a kör, és az XGI Technology maradéka beolvadt a SiS-be. Vissza a startmezőre? Nos, egy vesztes szemével nézhettük végig ezt a "társasjátékot".

Még több hasonló cikket olvasnál? Vedd meg a 2022/11-es PC World magazint, ráadásul ajándék szoftvereket és PC-s teljes játékot is kapsz, ha így teszel!