Néhány év alatt alaposan eldurvultak az elsőre ártatlannak tűnő arccserés játékok. Napjainkban megfelelő szakértelemmel gyakorlatilag bárkiről készíthető hamis videófelvétel, a gépi intelligencián alapuló algoritmusok ráadásul olyannyira gyorsan fejlődnek, hogy a ma még többnapos munka éveken belül néhány órára vagy akár percekre mérséklődhet.

Biztonsági kutatók a technológiákat és a lehetőségeket látva már információs armageddonról beszélnek, illetve többen elképesztően fejlett zsarolóvírusok terjedését vizionálják. A spear phishing-, más néven laser phishing-támadások a feltételezések szerint a közösségi oldalakról nyert fotók alapján könnyen reprodukálni tudják majd bárkinek az arcképét, hogy utána egy tetszőleges videóba illesszék azokat. Ha ez valóban megtörténik, akkor bárki egy gyilkosság vagy éppen egy házasságtörés elkövetőjének is feltüntethető lesz a tudta nélkül. Gyanítjuk, hogy kevesen fogják csak vállalni a hamis videók publikálásának erkölcsi kockázatát.

Okosabb MI, szegény mi

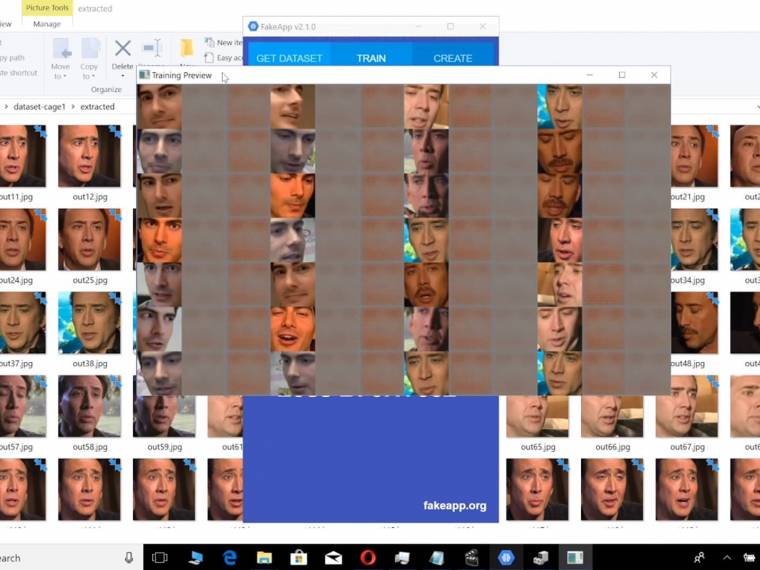

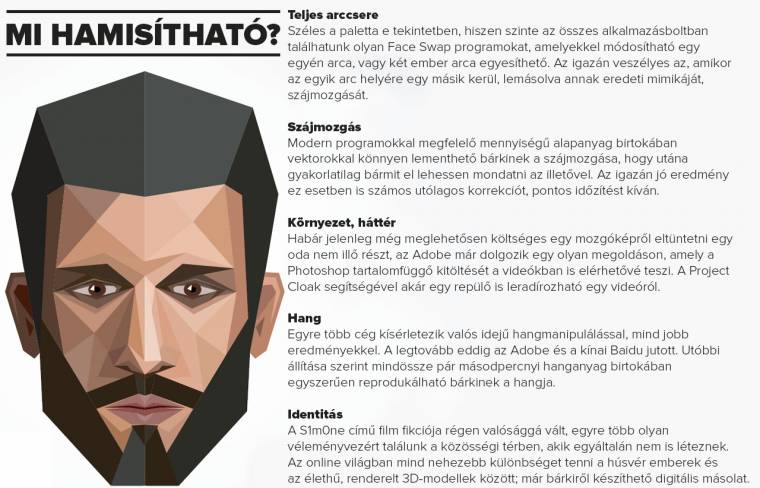

A következő bekezdésekben bemutatjuk, hogy a fejlett gépi intelligencián alapuló megoldásokkal gyakorlatilag már most is bármi hamisítható. A FakeApp 2.2 szakértő kezekben igazi fegyverré válik, amellyel gyakorlatilag bárkinek az arca egy teljesen idegen videofelvételre illeszthető. E módszerrel például Nicholas Cage színészt már többek között Indiana Jones bőrébe bújtatták, a rosszindulatú netezők pedig felnőttfilmekbe tettek be több híres hollywoodi színésznőt. Utóbbit nevezték elsőként deepfake-nek.

A veszélyes technológia térnyerését a gépi intelligencián alapuló megoldások fejlődésének köszönhetjük, amelyekkel jelentősen leegyszerűsödött a hamisítás. Míg a 2016-os Zsivány Egyes - Egy Star Wars-történet forgatásakor 200 millió dollárt költöttek a fiatal Leia hercegnő feltámasztására, tavaly év elején egy felhasználónak sikerült nagyjából ugyanazt a munkát elvégeznie egy délután alatt.

A háttérben gyakran a Google nyílt forrású TensorFlow (tensorflow.org) neutrális hálózatát találjuk, amely napról napra okosodik, ahogy egyre többen használják. Márpedig ingyenessége miatt rengeteg visszajelzést kap a gépi intelligencia, ami meg is látszik az eredményeken. A mesterséges intelligenciát (MI) emellett a versengő, más néven ellenséges hálózatok is segítik. Ez esetben két gépi intelligenciát alkalmaznak. Az egyik generálja a képeket (generator), a másik pedig ellenőrzi, megpróbálja felismerni azokat (discriminator), és visszajelez társának. E módszerrel gyakorlatilag a gépek egymást tanítják, a nem létező embereket és macskákat generáló oldalakon megtekinthető, hogy mennyire hatékonyak már most.

Fake news 2.0

A leghíresebb deepfake felvétel Jordan Peele-nek, a Tűnj el! és a jelenleg is a mozikban futó Mi rendezőjének köszönhető, aki 2018 tavaszán a FakeApp nevű programmal, majd After Effectsben történő utólagos szerkesztéssel körülbelül 56 óra alatt elkészített egy olyan egyperces Barack Obama-videót, amelyben gyakorlatilag a saját szövegét mondatta el az Egyesült Államok korábbi elnökével.

Peele már a videó leírásában figyelmeztetett arra, hogy felvétele hamis, ám felvetődik a kérdés, hogy mi történne akkor, ha valaki nem edukációs, hanem kifejezetten manipulatív célzattal használná fel a politikusok videóit, olyasmiket ismertetve be velük, amiket soha az életben nem követtek el.

Ez a hamis hírek egy újabb generációjának ágyazhat meg, és már tényleg nehéz vagy lehetetlen lesz az objektivitásra törekvő internetezőknek megállapítaniuk, hogy mi igaz, és mi nem. Félő, hogy teljesen elszakadhatunk a realitás talajától, és ez lesz a korábban már említett információs armageddon.

Aviv Ovadya, a Michigani Egyetem kutatója, aki korábban megjósolta a 2016-os közösségimédia-alapú választási csalásokat, már realitásapátiáról beszél a könnyen hamisítható felvételek kapcsán. Véleménye szerint hamarosan olyannyira általános lehet a deepfake jelenség, hogy az emberek nehezen tudnak majd különbséget tenni fikció és valóság között, amely belső konfliktus a tényektől való elforduláshoz is vezethet. Sőt hamis videók elkészülése sem szükséges ahhoz, hogy elbizonytalanodjanak az emberek, az is elég, hogy a technológia létezik. Donald Trump, az Egyesült Államok elnöke például egy kiszivárgott buszos hangfelvétel kapcsán már bevetette a hamis kártyát. Ez a taktika bármikor, bárhol működhet, és az ellenkezője is. Egyre nehezebb lesz eligazodni a világban, ami Aviv Ovadya szerint kitermeli majd az emberi bábokat, azokat az embereket, akiket kampánymenedzserek a megfelelően adagolt információkkal és hamisított tényekkel dróton tudnak rángatni.

Fogalommagyarázat

TensorFlow: A Google nyílt forrású gépitanulás- és neurálishálózat-rendszere, amelyre építve bárki létrehozhatja saját öntanuló alkalmazását. A TensorFlow található meg például a Google képkereső algoritmusa mögött is.

Deepfake: Egy portmanteau nevű Reddit-felhasználónak köszönhetjük a terminust, aki a deep learning és a fake kifejezések ötvözésével alkotta meg azt. Habár a felhasználó saját munkájának adta ezt a kódnevet, találóbb elnevezést azóta sem talált ki senkit.

GAN: Generatív ellenséges hálózatok rövidítése. A megoldás lényege, hogy két gépi intelligencia folyamatosan ellenőrzi a másikat, hibákat keresve alkotásában, majd az eredményt elküldi a vetélytársának. E megoldás rendkívül hatékony a képek generálásában.

DARPA: Az Egyesült Államok Védelmi Minisztériumának kutatásokért felelős részlege. Jelenleg több, deepfake-kel kapcsolatos projektet is támogat, állításuk szerint megelőzési célzattal.

Laser phishing: Modern támadási forma, amelynek során egy rosszindulatú mesterséges intelligencia megpróbál minél több információt begyűjteni a közösségi oldalakról az áldozattal kapcsolatban, majd azokkal támadást indítani; ez akár zsarolás is lehet.

Az új korszak hajnala

A deepfake kétségtelenül veszélyt jelent minden társadalomra, hiszen kevés esettől eltekintve létezése kártékony és romboló, és akár belülről is felbomlaszthat jelenleg még jól működő társadalmakat. A CNN tudósítása alapján a Pentagon ennek tudatában már készül az új információs korszakra, az Egyesült Államok Védelmi Minisztériumának kutatásokért felelős részlege jelenleg több deepfake-technológiával kapcsolatos kutatást is támogat több millió dolláros értékben. Céljuk egyrészt a gépi intelligencia által készített felvételek hatékony leleplezése, másrészt mérget vennénk arra, hogy annak hadászati célú bevetését is vizsgálják. A cél egy olyan algoritmus kifejlesztése, amely képes kiszűrni a más algoritmusok által készített felvételeket, hangfájlokat. Nagyjából úgy kell elképzelni, mint egy vírusvédelmet, csak éppen teljesen más szinten működik.

Ez a fajta védelem az elkövetkező években szinte biztosan nem áll majd a felhasználók rendelkezésére, akiknek így csupán a kritikus gondolkodás marad egyetlen eszközként, hogy kiszűrjék a hamis információkat. Utóbbi viszont rendkívül fontossá válik majd. A kamufelvételek szerencsére könnyen lebuktathatók, ha figyelembe veszel néhány szabályt. Egyrészt mindig ellenőrizd a forrást, ahonnan az információ származik. Ha nehezen hihető a benne foglalt állítás, nézz utána más, általad hitelesnek tekintett forrásokból. Videókon nézd meg alaposan a száj mozgását, ha valahol nincs a hanggal szinkronban, gyanakodhatsz a deepfake jelenségre. A gépek által generált kép nem mindig pontos, így érdemes a felvételeket lelassítani, így láthatóbbá téve az esetleges hibákat. Végezetül nemcsak a konklúzióra érdemes figyelni, hanem a levezetésre is, hiszen ha hamis, annak kidolgozásával vélhetően kevesebbet foglalkoztak.